没点本事,还真搞不了数据云!

发布时间

2023-04-04

分享

如今,这个概念↑几乎人人皆知了吧

所以无论C端还是B端的客户

都开始把自家的数据当宝贝

既想“深度挖掘”,又想“严防死守”

尤其最近,“GPT”连连放卫星

彻底拉响数据市场新一轮升级的号角

然鹅,玩“大模型”→就要“大数据”

数据流通不畅的问题更凸显了

↓

这些数据单一组织根本凑不齐

自家数据自己捂,别家数据别人捂

大家彼此互相防着

结果,所有人都只能干着急

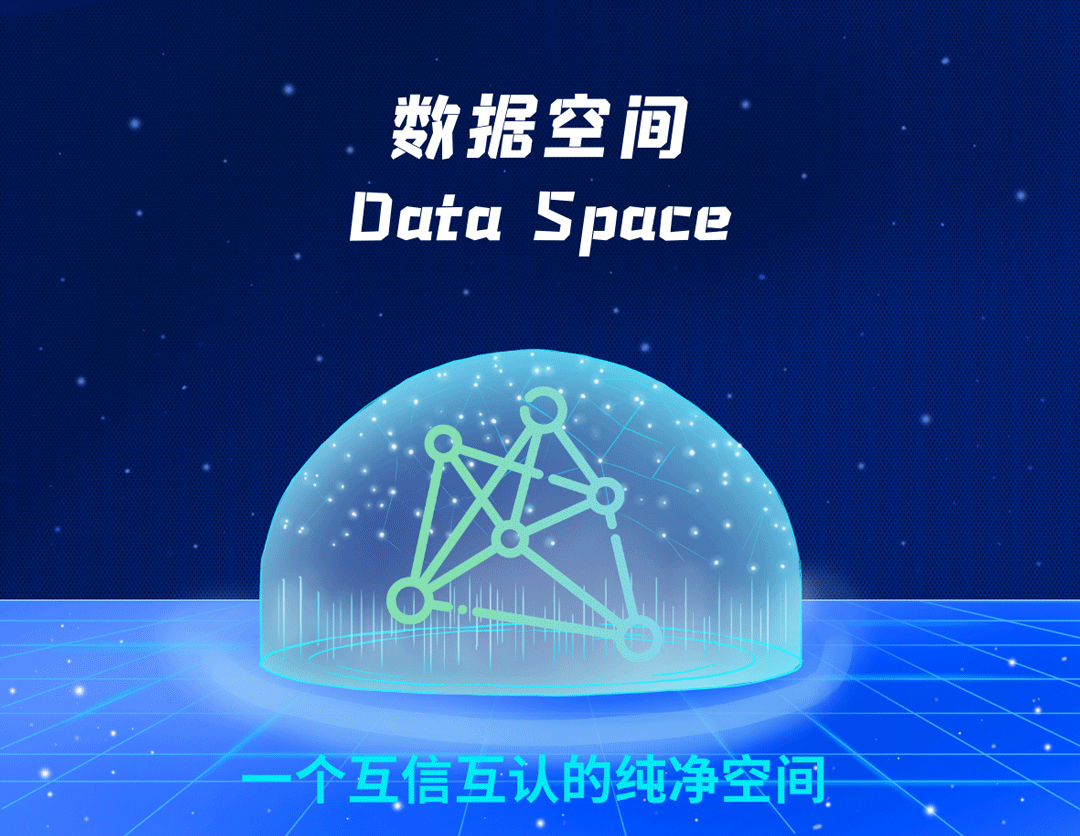

如何破局?专业人士提出了新的概念

构建一个理想的空间

数据空间(Data Space)

基于「可用不可见、可控可计量」的理念

让数据在这个空间里

可信安全地自由流动和使用

↓

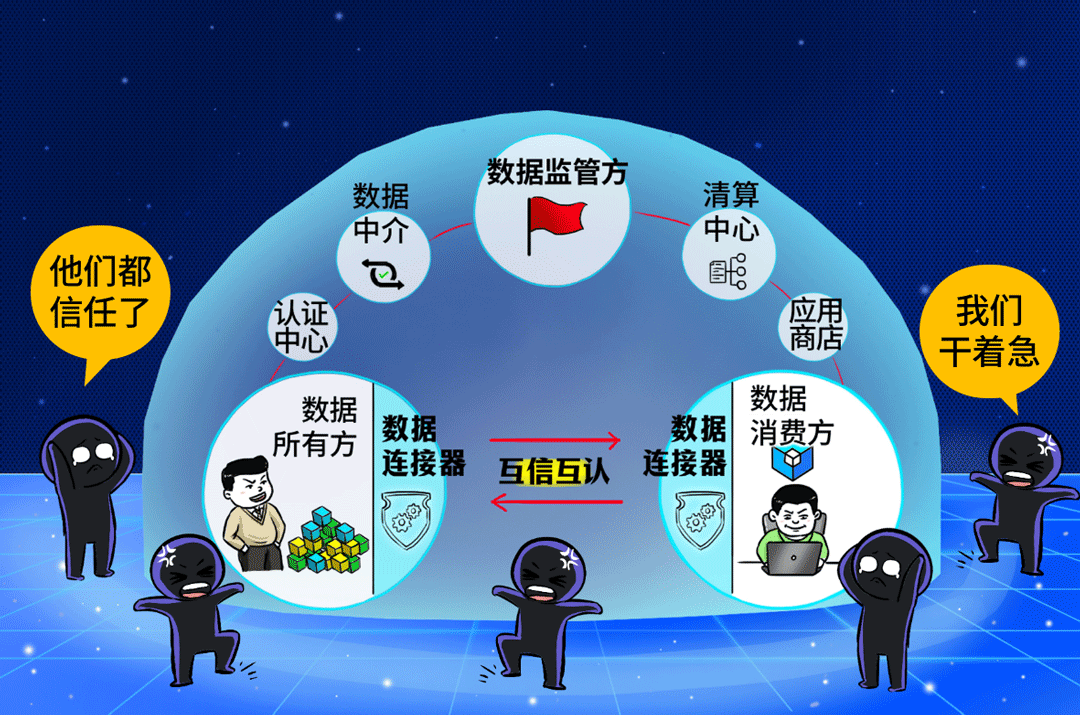

空间里有很多种角色

数据所有者丨数据消费者

数据监管方丨数据中介丨数据清算方

以及认证中心、应用商店这些组件

数据空间好比一个安全的大房子

构建这个房子的“钢筋水泥”

那就是

↓

【数据云】

就变成了简单轻松的小工程

那接下来的问题又变成了

数据云在哪儿

嘿嘿,真巧

上周,浪潮云在北京发布了

浪潮数据云

↓

浪潮云的一大特点就是

对市场敏感度极高

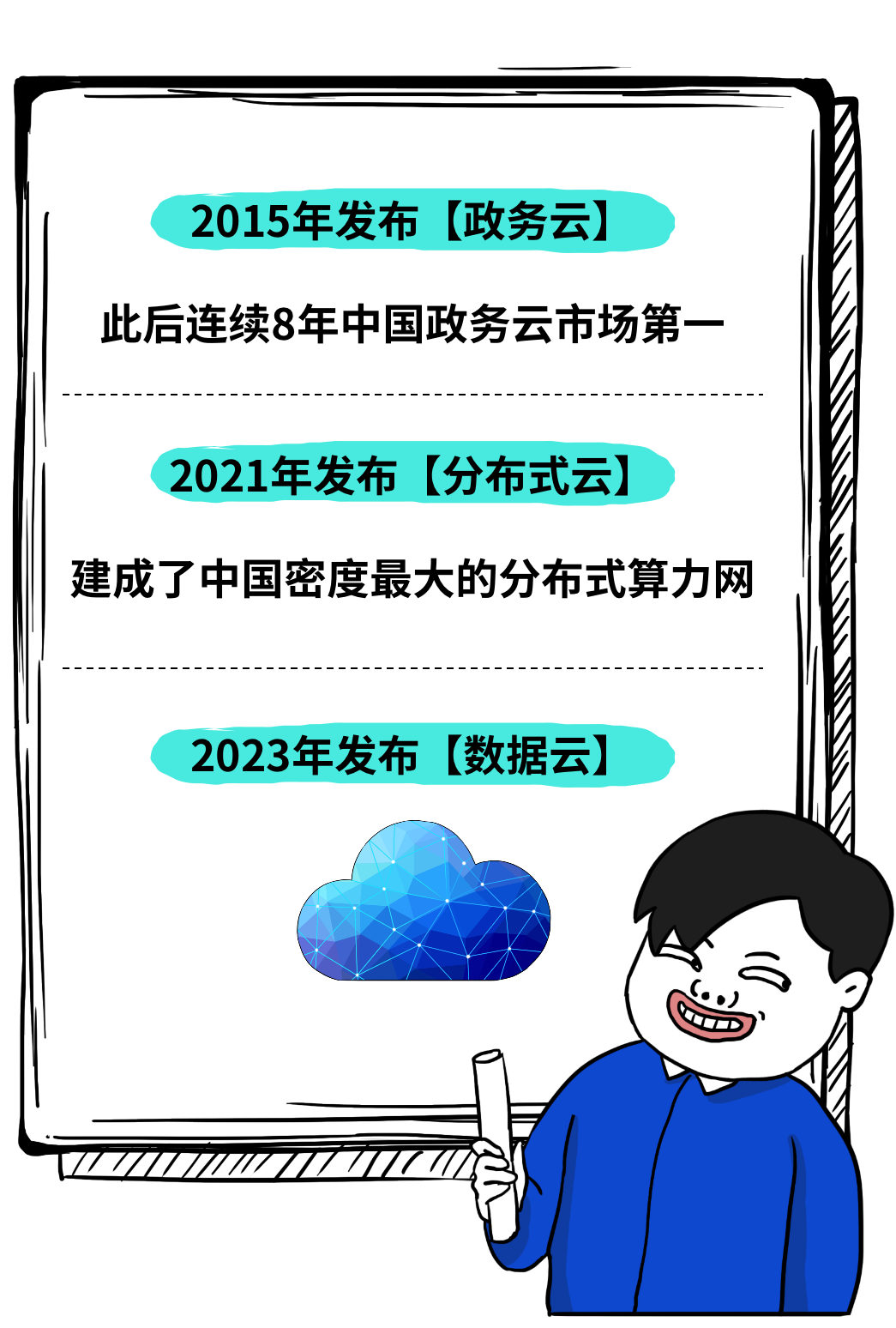

浪潮云成立十年

总共放了三次大招(业务战略发布)

每次对行业需求踩点都极准

所以这一次

「浪潮数据云」来的正是时候

它从四个阶段入手

数据采集丨数据计算丨数据应用丨数据流通

完美切中了用户数据流动和共享的需求

![]()

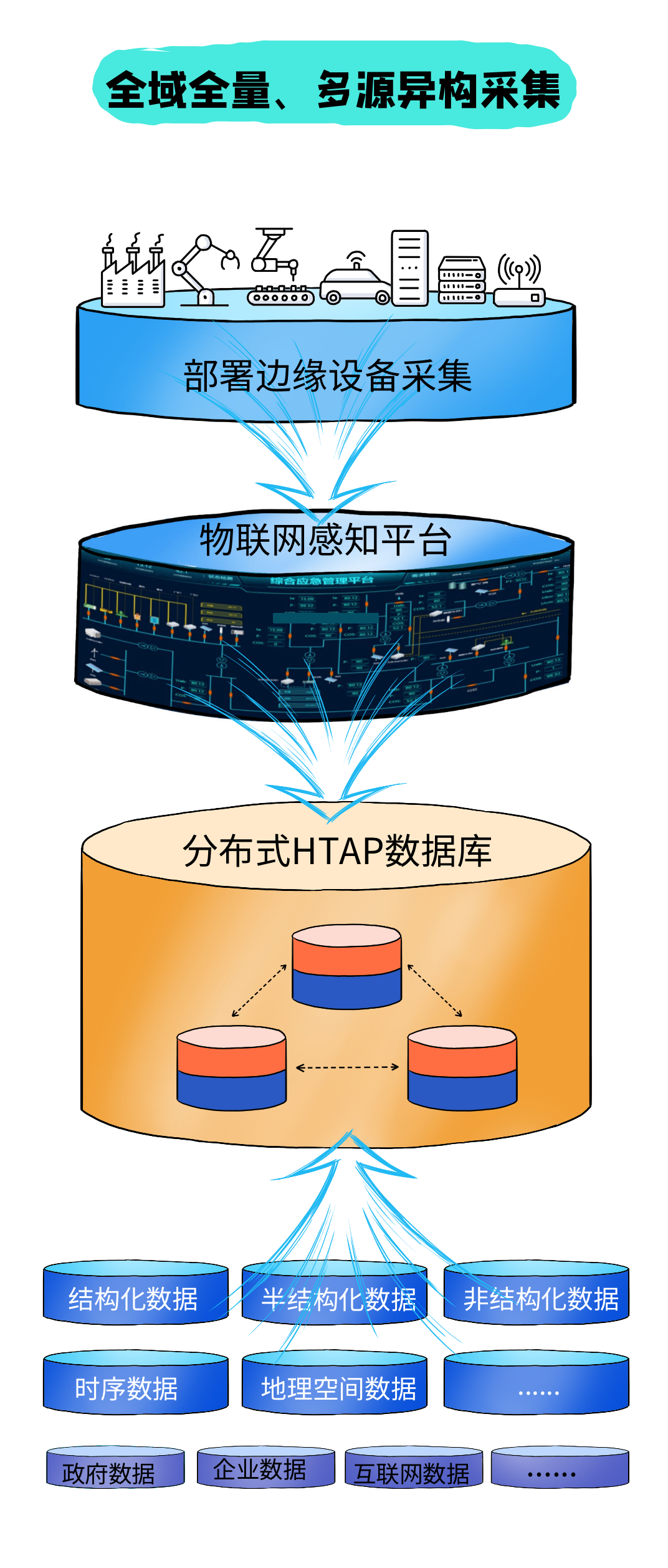

第一,在数据采集阶段

首先,帮助客户做全域全量采集

通过浪潮云的边缘设备和物联网平台

帮助客户实现

跨系统、跨部门、跨场景、跨平台

采集所有可用数据

并确保数据的完整性和准确性

接下来,做「数据预处理」

让数据成为标准数据,达到可用状态

↓

每家采集的数据五花八门

不同年代、不同来源、不同类型、不同结构、不同质量...

这样的数据无法成为“资产”

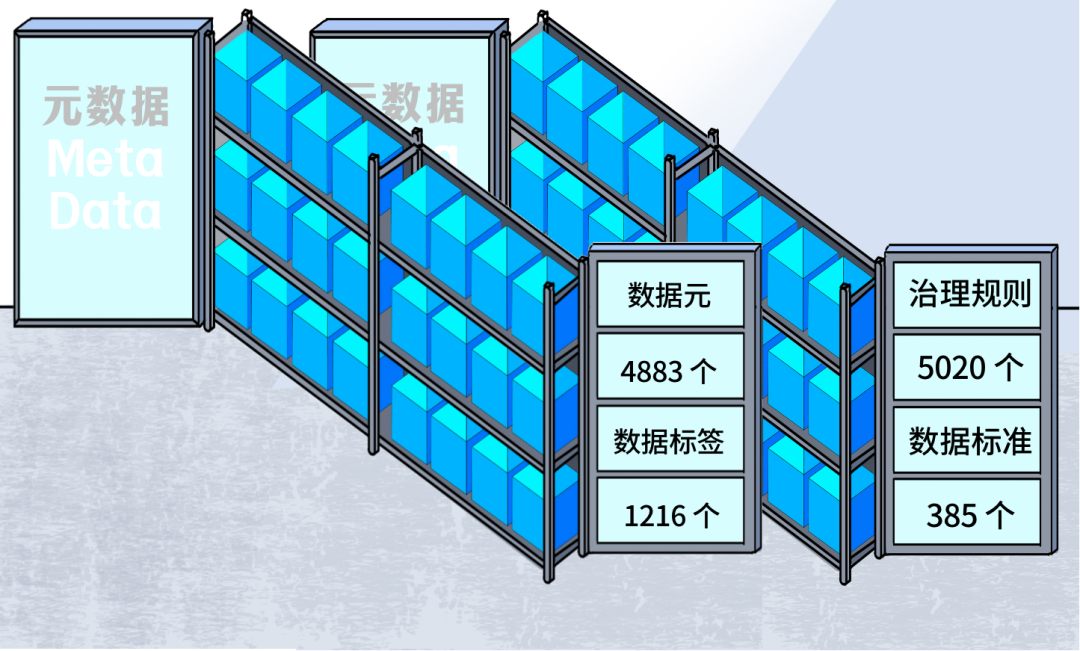

「浪潮数据云」提供方法论和工具

通过「数据治理工厂」进行加工

这个工厂非常智能化

治理周期从30人天缩减至4人天

最后,把梳理好的数据资产

进行精确标记

至此,数据资产一目了然

随时可以调用

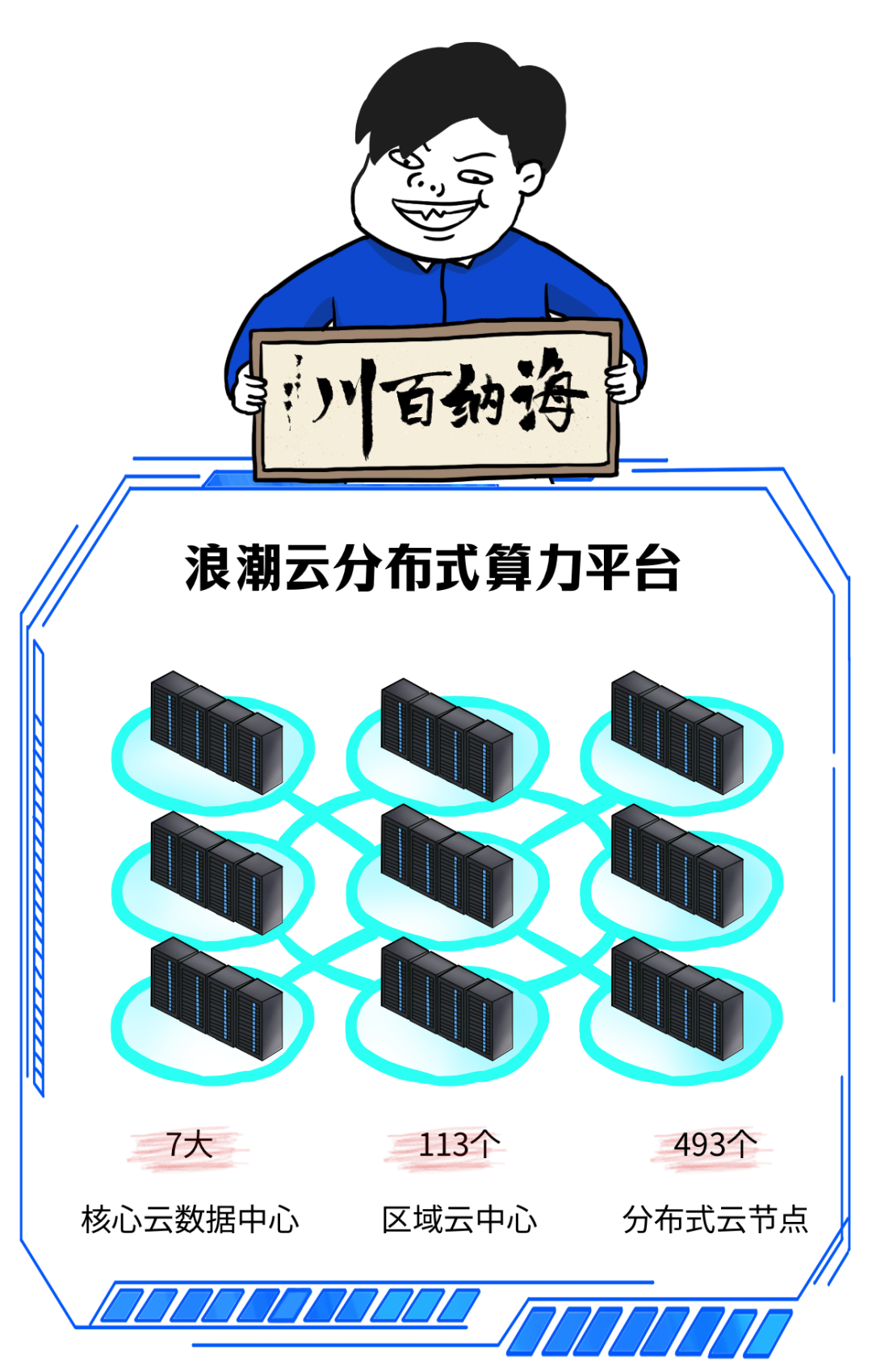

第二,在数据计算阶段

为客户提供海量数据的高性能计算

目前浪潮云已在全国建成了

超大规模的分布式云体系

↓

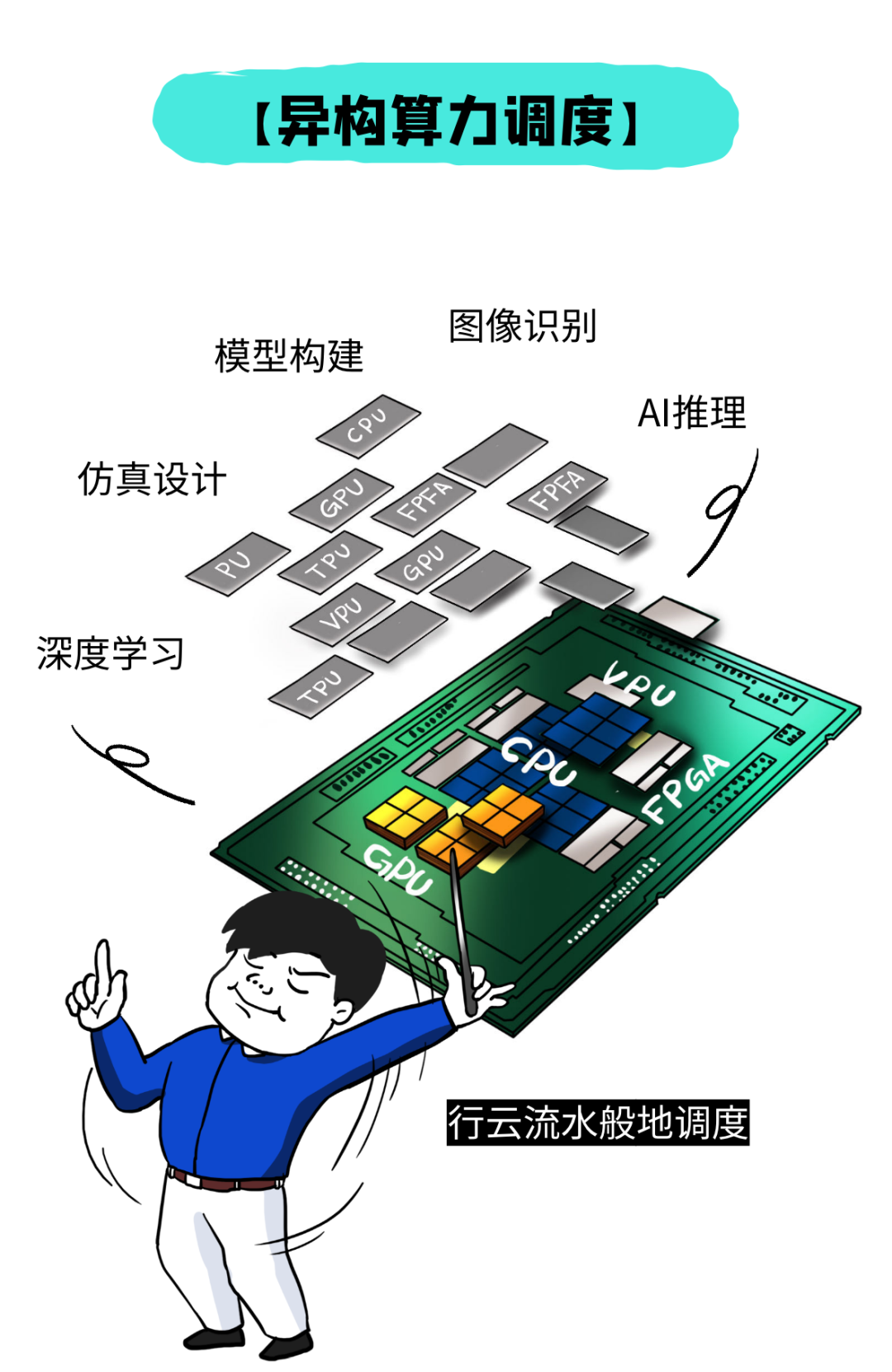

同时,根据客户不同应用场景

按需调度算力

深度学习,调度GPU算力

视频分析,调度VPU算力

仿真设计,调度FPGA算力...

↓

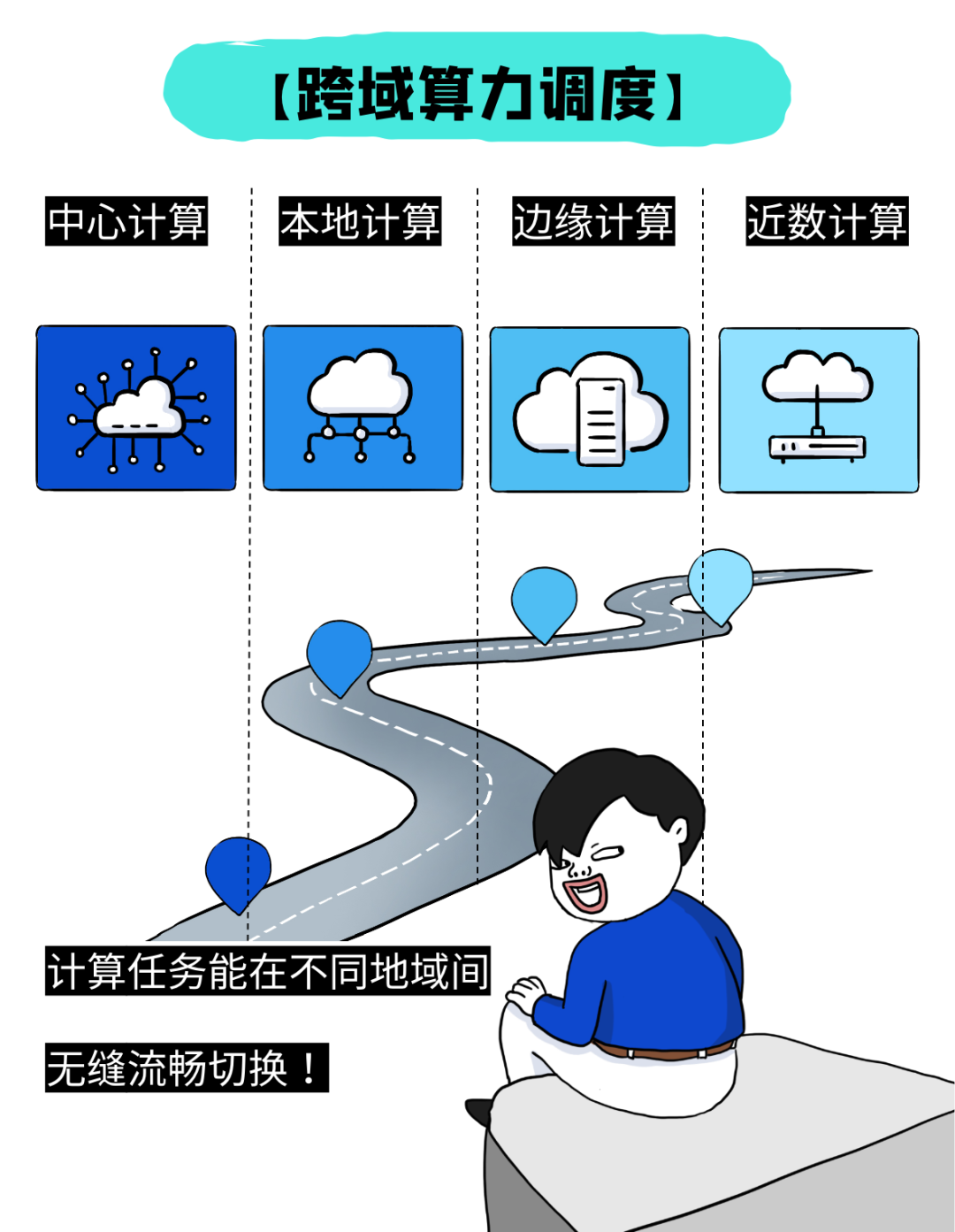

再比如

江浙沪客户热数据匹配东部算力

而冷数据调度西部算力

浪潮数据云就能够提供

跨域算力调度

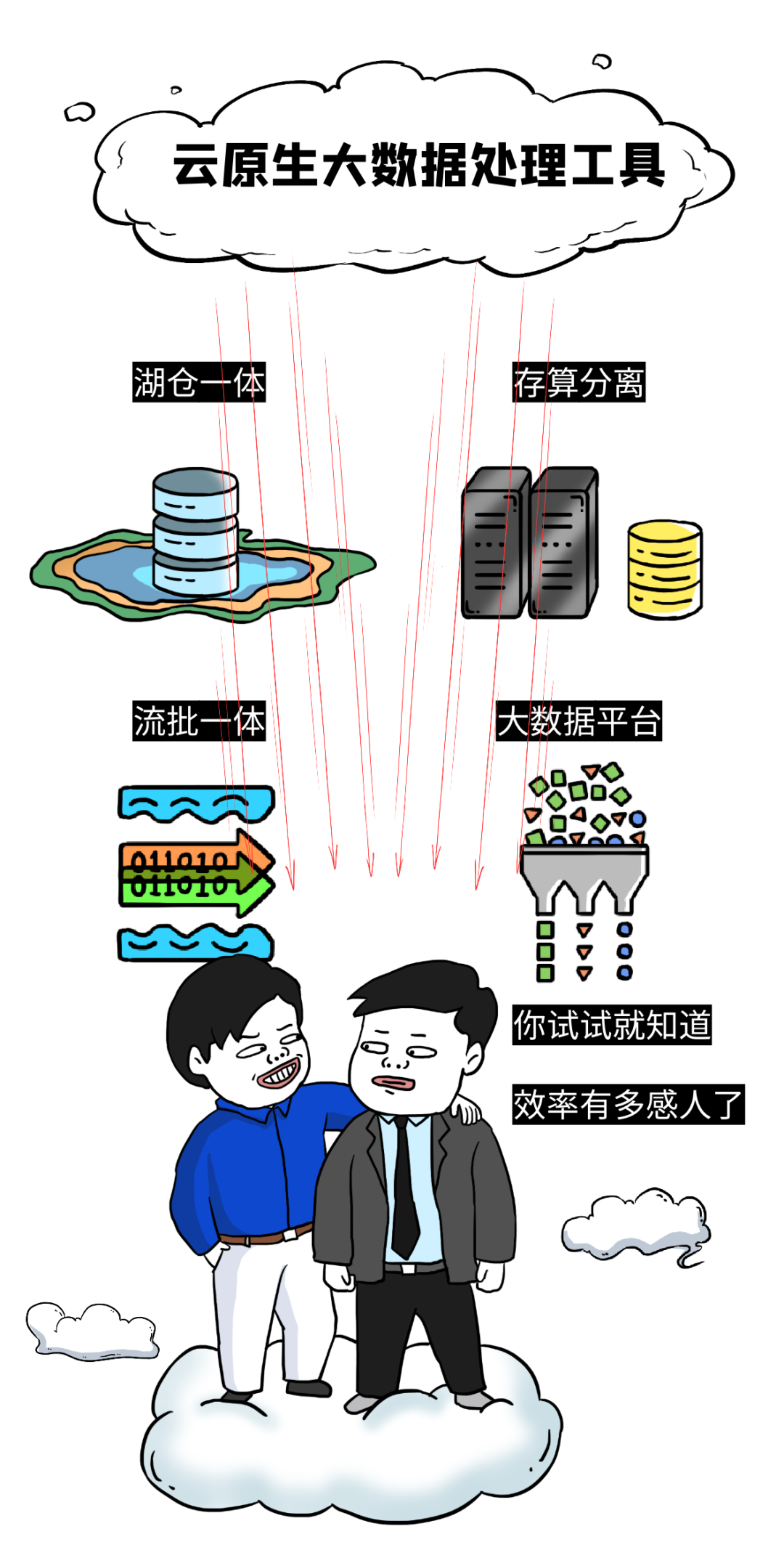

接下来

提供「云原生」的大数据处理工具

让客户在云上轻松完成数据处理工作

不需要把数据搬上搬下

数据处理效率提升30%以上

↓

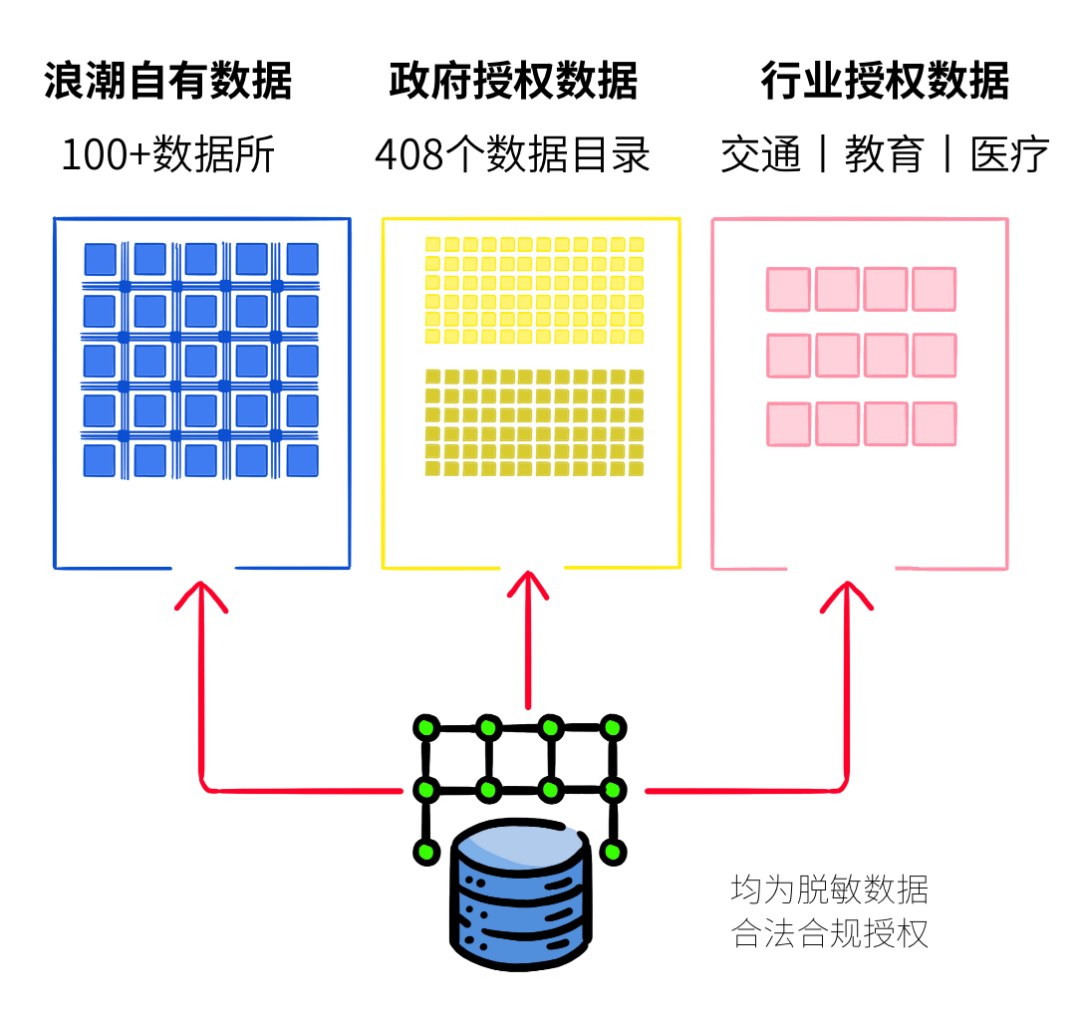

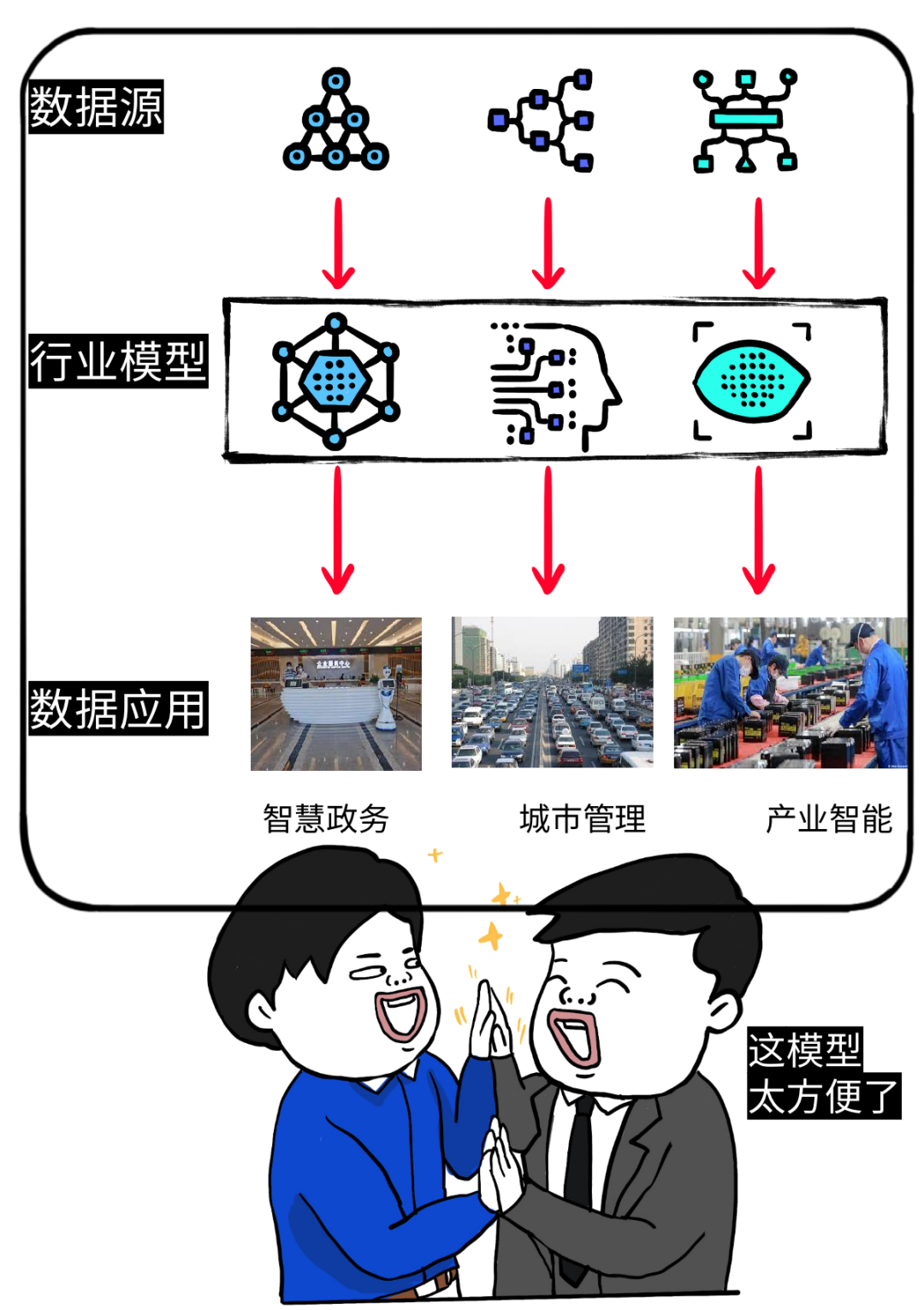

第三,在数据应用阶段

目前浪潮数据云有自己的一些数据储备

主要有三大类

浪潮自有数据丨行业授权数据丨公共授权数据

(强调一下,这些均为脱敏数据、合法合规授权获取)

同时,还提供好用的“行业模型”

云上即开即用,只要接上数据源

一个新应用立刻就能跑起来

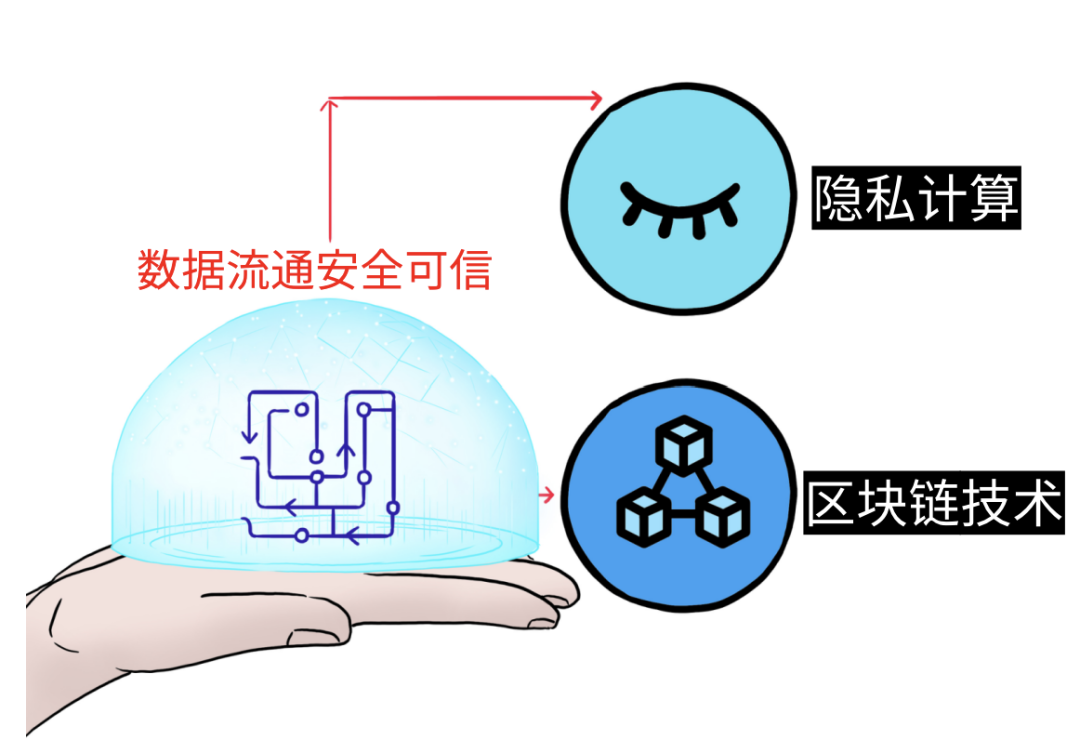

第四,在数据流通阶段

只要数据流动,就会存在安全风险

这是所有CIO的顾忌之一

就像我们最开始所说的那样

这成了当下数据发挥价值的最大障碍

「浪潮数据云」从两方面入手

解决客户心头大患,「安全可信」问题

1、通过隐私计算和区块链技术

为客户定制安全可信的数据流通环境

也就是我们前面说的「数据空间」

基于此,真正实现

数据不动模型动、数据可用不可见、数据可信可追溯

2、通过「安全运营中心」

帮助客户实现数据流通全程监测

所有的数据流通过程

可视化、可追溯、可审计

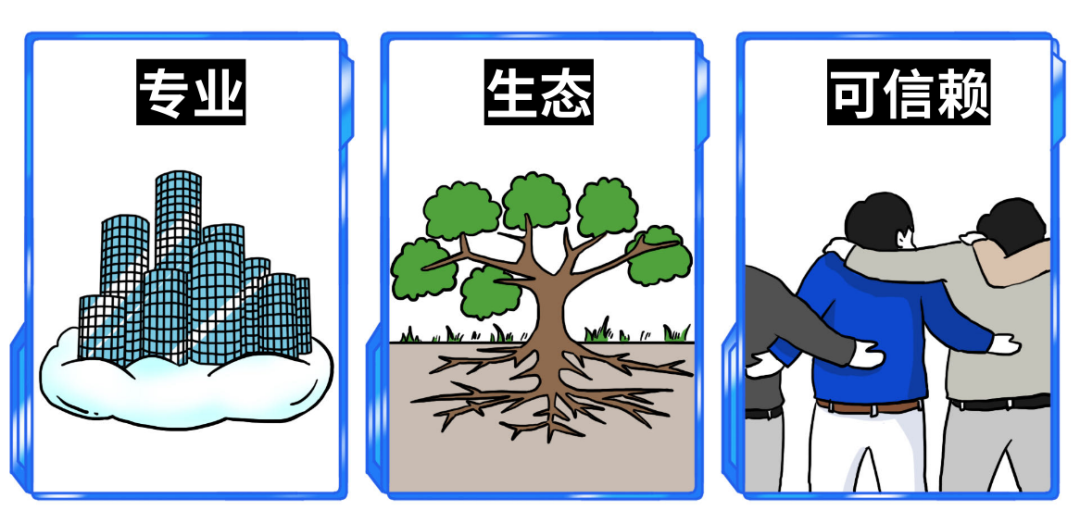

总结一下,「浪潮数据云」带来了什么

「浪潮数据云」的核心优势是什么?

我认为有两个层面

切中DOS作为落地方式的高效模式

第二,浪潮云自身基本盘的优势强大

多年数据运营经验,专业性强

拥有完善的政务云生态群

企业背景深得客户和伙伴信赖

在这两大优势铺垫下

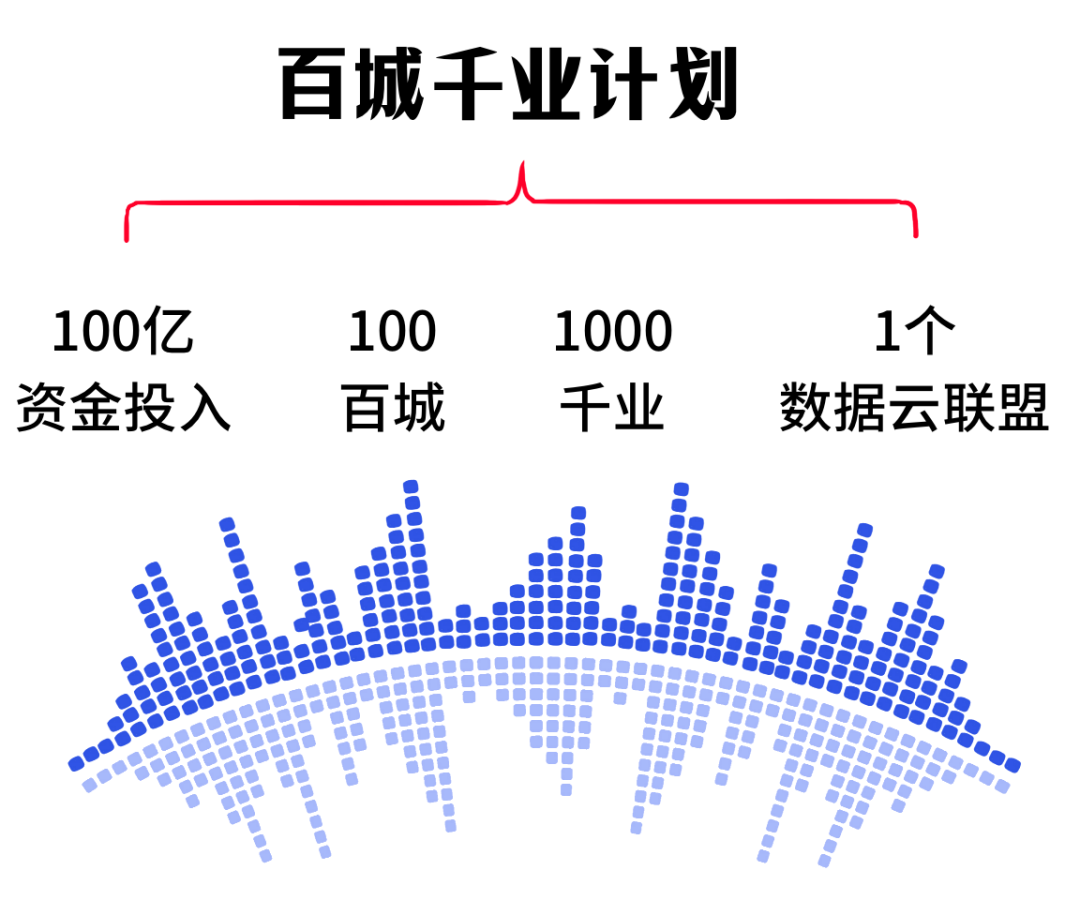

「浪潮数据云」又开启了一项新计划

↓

腾云赋智,踏浪而行